Google Search Consoleで「Indexed, though blocked by robots.txt」という警告通知を受け取った場合、検索エンジンの結果ページ(SERPS)でページがランク付けされる能力に影響を与えている可能性があるため、できるだけ早く修正することをお勧めします。

あるrobots.txtファイルは、ウェブサイトのディレクトリ内に存在し、Googleのボットのような検索エンジンのクローラーに対して、どのファイルを閲覧すべきか、または閲覧すべきでないかの指示を出すファイルです。

「Indexed, though blocked by robots.txt」とは、Googleがあなたのページを見つけたものの、robotsファイルにそれを無視する指示が見つかったことを意味しています(つまり、結果には表示されません)。

これは意図的な場合もあれば、以下に概説されているいくつかの理由により偶発的な場合もあり、修正可能です。

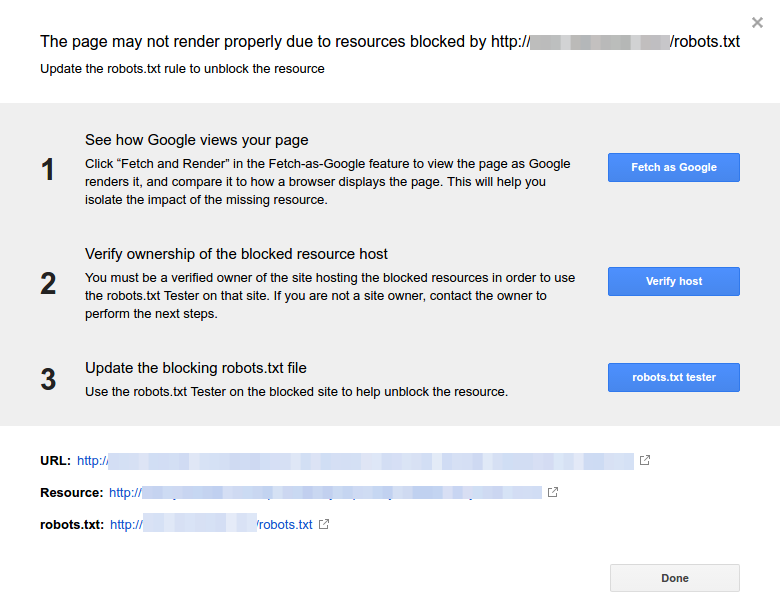

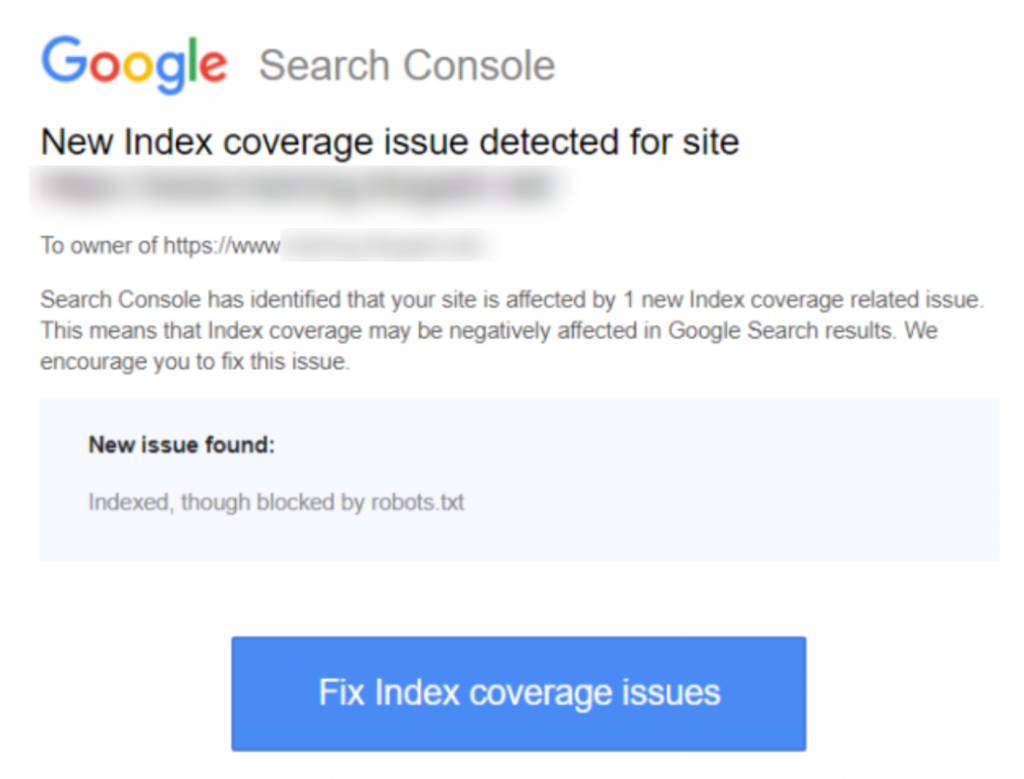

通知のスクリーンショットはこちらです:

影響を受けるページまたはURLを特定する

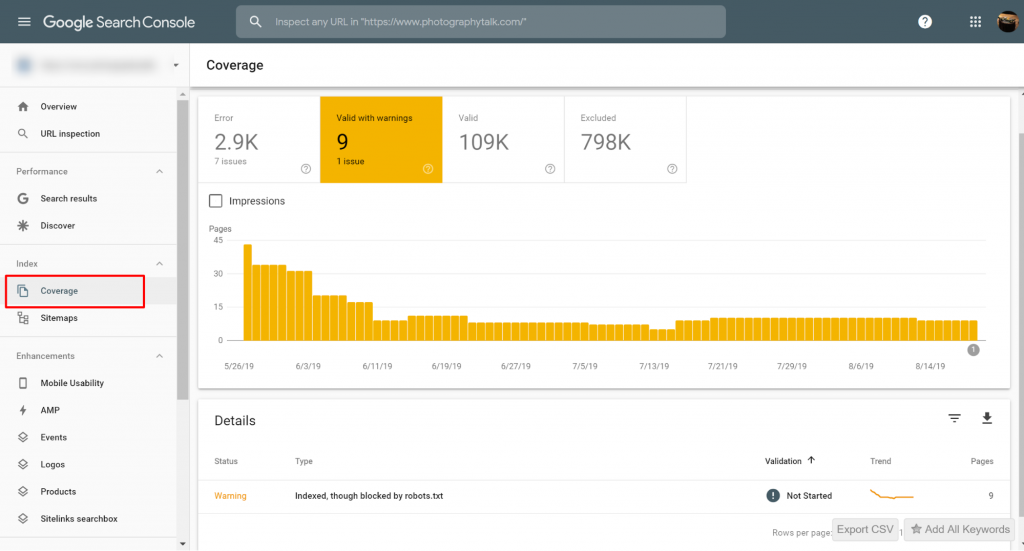

Google Search Console (GSC)から通知を受け取った場合、問題となっている特定のページまたはURLを特定する必要があります。

Google Search Console>>カバレッジで、robots.txtによってブロックされているがインデックスされている問題のページを表示することができます。警告ラベルが表示されない場合は、問題ありません。

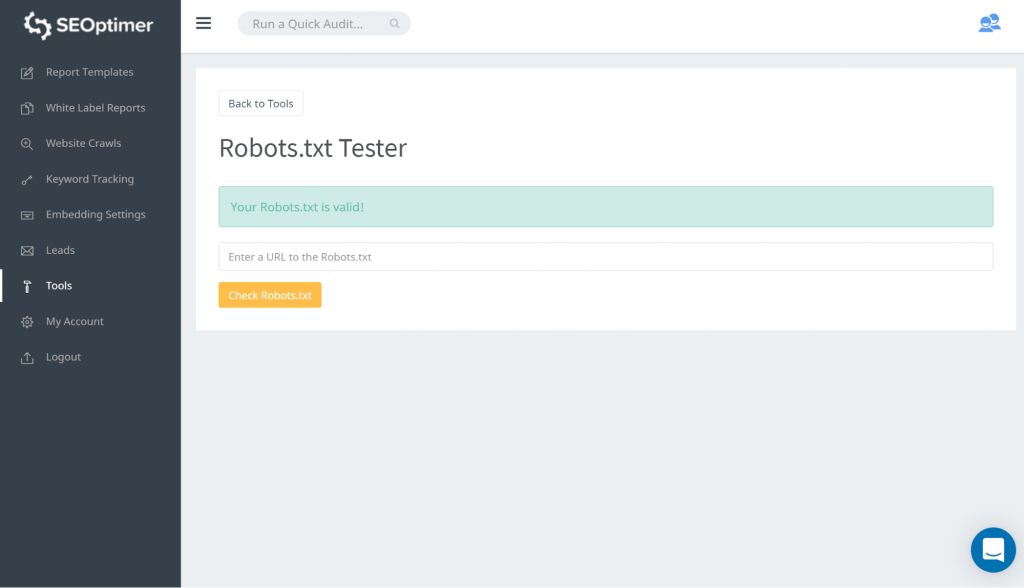

robots.txtをテストする方法の一つは、私たちのrobots.txt testerを使用することです。ブロックされているものがそのまま「ブロック」されていることに問題がないと感じるかもしれません。したがって、何も行動を取る必要はありません。

また、このGSCリンクをフォローすることもできます。その後、以下の手順を踏む必要があります:

- ブロックされたリソースのリストを開き、ドメインを選択してください。

- 各リソースをクリックします。このポップアップが表示されるはずです:

通知の理由を特定する

通知はいくつかの理由によって発生する可能性があります。ここに一般的なものを挙げます:

しかし最初に、robots.txtによってブロックされているページがあることは必ずしも問題ではありません。それは、開発者が不必要な/カテゴリーページや重複をブロックしたいという理由で設計された可能性があります。では、不一致とは何でしょうか?

間違ったURL形式

時々、問題は実際にはページではないURLから生じることがあります。例えば、URLが https://www.seoptimer.com/?s=digital+marketing の場合、そのURLがどのページに解決するかを知る必要があります。

もしそれがユーザーに必ず見てもらいたい重要なコンテンツを含むページであるならば、URLを変更する必要があります。これはWordpressのようなコンテンツ管理システム(CMS)で可能で、ページのスラッグを編集できます。

もしページが重要でない、または/?s=digital+marketing の例で言えば、私たちのブログからの検索クエリであれば、GSCのエラーを修正する必要はありません。

インデックスされているかどうかは関係ありません。なぜならそれは実際のURLではなく、検索クエリだからです。あるいは、ページを削除することもできます。

インデックスされるべきページ

インデックスされるべきページがインデックスされないいくつかの理由があります。以下はそのいくつかです:

- robots指示を確認しましたか? 実際にインデックスされるべきページのインデックスを禁止する指示をrobots.txtファイルに含めている可能性があります。例えば、タグやカテゴリーです。タグとカテゴリーはあなたのサイト上の実際のURLです。

- Googlebotにリダイレクトチェーンを指示していますか? Googlebotは出会うことができるすべてのリンクを通過し、インデックスのために読むことを最善を尽くします。しかし、複数で長く深いリダイレクションを設定した場合、またはページが単に到達不可能である場合、Googlebotは探すのをやめるでしょう。

- 正しいカノニカルリンクを実装しましたか? カノニカルタグはHTMLヘッダーで使用され、重複したコンテンツの場合にどのページが優先されるカノニカルページであるかをGooglebotに伝えるために使用されます。すべてのページにはカノニカルタグが必要です。例えば、スペイン語に翻訳されたページがあるとします。スペイン語のURLを自己カノニカルし、デフォルトの英語版にページをカノニカルしたいと考えるでしょう。

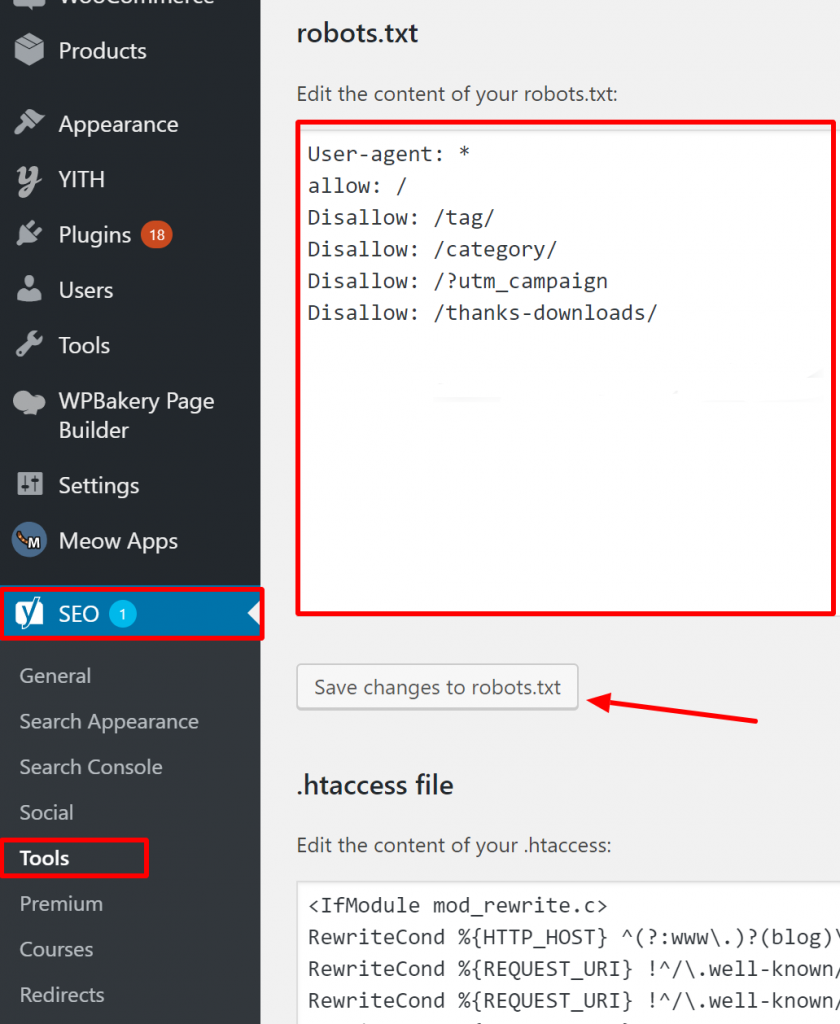

WordPressでRobots.txtが正しいかどうかを確認する方法は?

WordPressの場合、robots.txtファイルがサイトインストールの一部である場合は、Yoastプラグインを使用して編集してください。問題を引き起こしているrobots.txtファイルが自分のサイトではない別のサイトにある場合は、そのサイトの所有者に連絡して、robots.txtファイルを編集するように依頼する必要があります。

インデックスされるべきではないページ

インデックスされるべきではないページがインデックスされるいくつかの理由があります。ここにいくつかあります:

ページがインデックスされるべきではないと「言う」Robots.txtのディレクティブ。検索エンジンボットがページをインデックスすべきではないと「知る」ためには、'noindex'ディレクティブでページのクロールを許可する必要があります。

robots.txtファイルにおいて、以下を確認してください:

- 「disallow」行は「user-agent」行に直接続いていません。

- 「user-agent」ブロックは1つ以上存在しません。

- 不可視のUnicode文字 - robots.txtファイルをエンコーディングを変換するテキストエディタを通して実行する必要があります。これにより、特殊文字が削除されます。

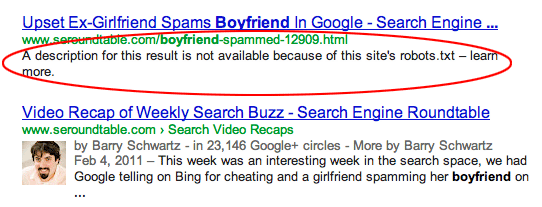

他のサイトからリンクされているページ。robots.txtで禁止されていても、他のサイトからリンクされているページはインデックスされることがあります。しかし、この場合、検索エンジンの結果にはURLとアンカーテキストのみが表示されます。これが検索エンジンの結果ページ(SERP)においてこれらのURLが表示される方法です:

画像ソース Webmasters StackExchange

画像ソース Webmasters StackExchange

robots.txtのブロッキング問題を解決する一つの方法は、サーバー上のファイルをパスワード保護することです。

または、robots.txtからページを削除するか、以下のメタタグを使用してブロックします

彼ら:

<meta name="robots" content="noindex">

古いURL

新しいコンテンツや新しいサイトを作成し、それがインデックスされないようにrobots.txtで「noindex」ディレクティブを使用した場合、または最近GSCにサインアップした場合、robots.txtによってブロックされた問題を解決するには2つのオプションがあります:

- Googleに時間を与えて、最終的に古いURLをインデックスから削除させる

- 古いURLを現在のものに301リダイレクトする

最初のケースでは、GoogleはURLが404を返すだけであれば(つまりページが存在しないことを意味します)、最終的にそのURLをインデックスから削除します。404をリダイレクトするためのプラグインを使用することはお勧めできません。プラグインが原因で問題が発生し、GSCから「robots.txtによってブロックされました」という警告を受ける可能性があります。

バーチャルrobots.txtファイル

robots.txtファイルがなくても通知を受け取る可能性があります。これは、例えばWordPressのようなCMS(カスタマーマネジメントシステム)ベースのサイトには仮想のrobots.txtファイルがあるためです。プラグインにもrobots.txtファイルが含まれていることがあります。これらがあなたのサイトで問題を引き起こしている可能性があります。

これらの仮想 robots.txt は、あなた自身の robots.txt ファイルによって上書きされる必要があります。あなたの robots.txt には、すべての検索エンジンボットがあなたのサイトをクロールできるようにする指示が含まれていることを確認してください。これが、インデックスする URL かどうかを彼らが判断する唯一の方法です。

すべてのボットがあなたのサイトをクロールできるようにする指示です:

User-agent: *

Disallow: /

結論

私たちは「Indexed, though blocked by robots.txt warning」について、それが何を意味するのか、影響を受けるページやURLを特定する方法、そして警告の背後にある理由について見てきました。また、それを修正する方法についても見てきました。この警告があなたのサイトのエラーに等しいわけではないことに注意してください。しかし、修正しないと、最も重要なページがインデックスされない可能性があり、それはユーザー体験にとって良くありません。