クロールの深さは、Googleがコンテンツをどれだけ効率的にインデックスできるかに影響します。

Googlebotは限られた時間とサーバーリソースを持っています。したがって、クロール予算、つまり特定の時間枠内でGooglebotがあなたのサイトでクロールできるページ数は有限です。

クロールの深さはユーザーエクスペリエンスにも影響を与えます。訪問者は、複雑なナビゲーションや過度な深さのために重要なコンテンツが見つけにくい場合、必要な情報にアクセスするのに苦労するかもしれません。

この記事では、クロールデプスが何を意味するのか、そしてなぜSEOにおいて重要なのかを説明します。

さらに、ウェブサイトのクロールの深さを改善して、検索エンジンのパフォーマンスを向上させるためのいくつかのヒントを共有します。

SEOにおけるクロールデプスとは何ですか?

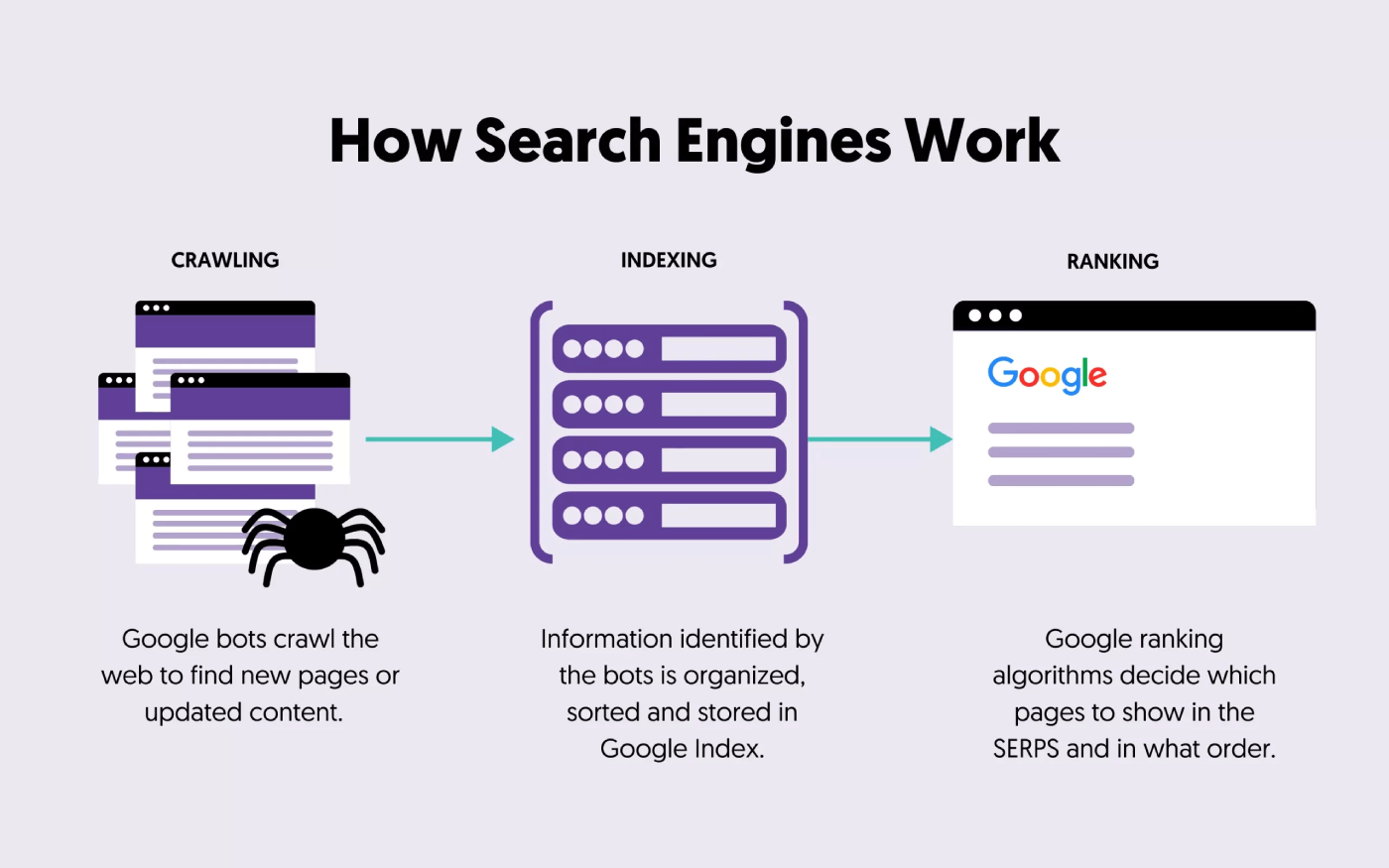

クロールの深さは、ホームページから測定したときに、ウェブサイトの階層内でウェブページが位置するレベルまたは距離を指します。

それは、検索エンジンのウェブクローラーがウェブサイトのホームページから特定のページに到達するまでに何回のクリックまたはステップを要するかを表しています。クロールの深さは、検索エンジンがどれだけ効果的にウェブサイトのコンテンツを発見してインデックスするかに影響を与える可能性があるため重要です。

次の構造を持つウェブサイトがあると想像してください:

ホームページ > カテゴリA > サブカテゴリA1 > ページ1

この例では、ホームページのクロール深度は0です。なぜなら、それが出発点だからです。サブカテゴリA1のクロール深度は2です。なぜなら、ホームページから2クリック離れているからです。そして、ページ1のクロール深度は3です。なぜなら、それはホームページから3クリック離れているからです。

SEOにおけるクロールの深さが重要な理由は何ですか?

SEOにおいてクロールの深さが重要な理由はいくつかあります:

- インデックス効率:ウェブサイトの構造の深くに埋もれたページは、ホームページに近いページほど頻繁にクロールやインデックスされないかもしれません。

- リンクエクイティ:ホームページに近いページは、内部リンクと外部リンクを通じてより多くのリンクエクイティ(権威)を受け取ることが多いです。これは、検索エンジンのランキングと可視性に影響を与える可能性があります。

- ユーザーエクスペリエンス:複雑で深いウェブサイトの構造は、ユーザーや検索エンジンが重要なコンテンツを見つけることを難しくし、潜在的には悪いユーザーエクスペリエンスにつながる可能性があります。

- 新鮮さ:クロールの深さが浅いページは、頻繁にクロールされる可能性が高く、検索エンジンが更新や変更をより迅速に検出してインデックスすることができます。

クロールの深さの効率を上げる方法

クロールの深さの効率を向上させる最良の方法のいくつかはこちらです:

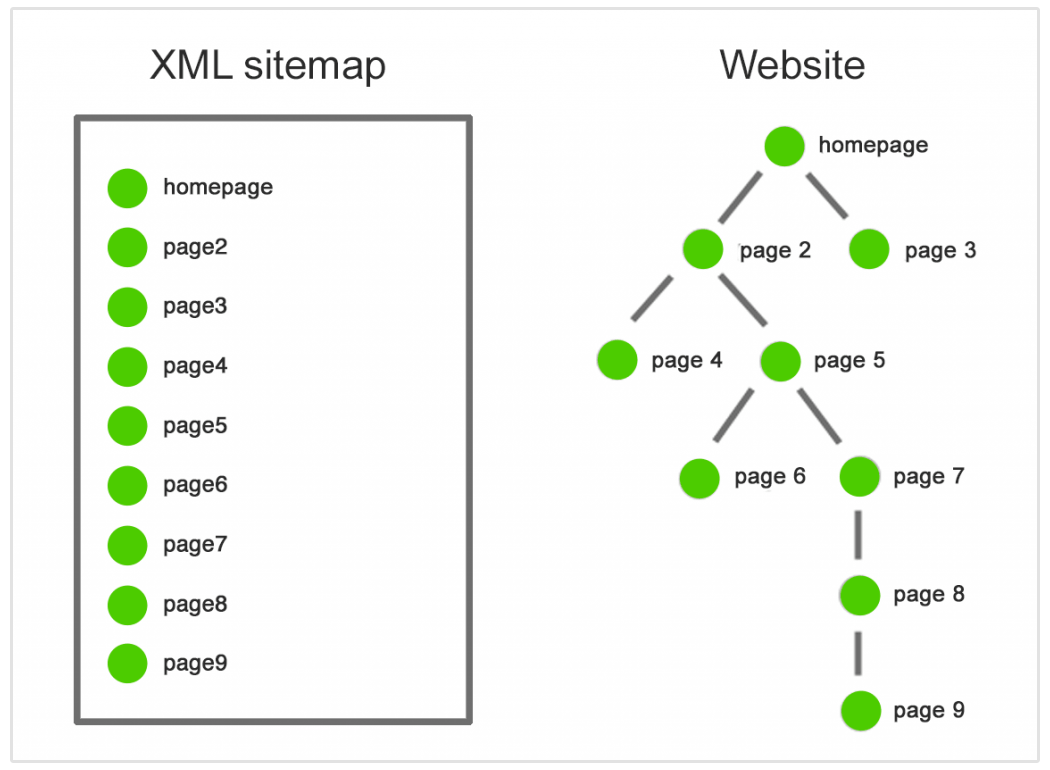

定期的にサイトマップを更新する

サイトマップを送信することで、検索エンジンがあなたのウェブページを素早くクロールしてインデックスするのを簡単にします。

サイトマップは動的であるべきであり、常にあなたのウェブサイトの最新の状態を反映していることが重要です。

新しいページを追加したり、既存のページを更新したり、古いコンテンツを削除する際には、サイトマップを適宜更新することを忘れないでください。これにより、検索エンジンが常にあなたのウェブサイトのURLの正確で包括的なリストにアクセスできるようになります。

ウェブサイトのナビゲーションと構造を改善する

ウェブサイトのナビゲーションと構造を改善することは、ウェブデザインとSEOにとって基本的です。

ナビゲーションメニューを合理化し、コンテンツを論理的に分類し、明確で説明的なラベルを使用してください。ウェブサイトの明確な階層を作成し、サブカテゴリとページが関連する親カテゴリの下に整理されていることを確認してください。

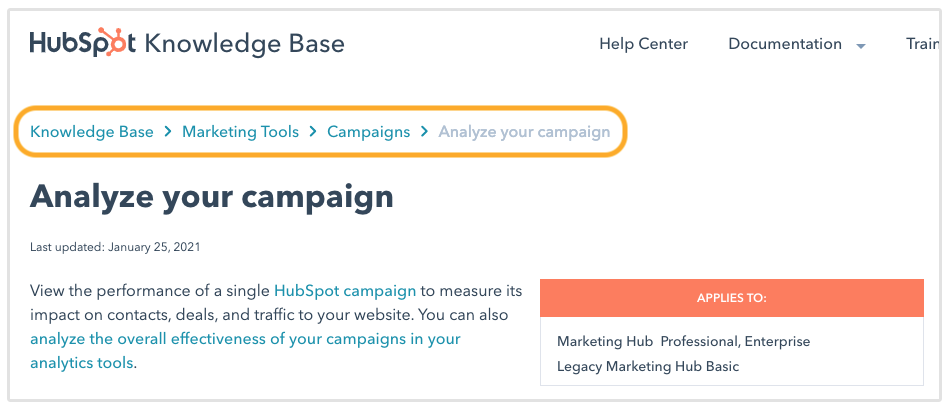

「パンくずリスト」ナビゲーションを実装することで、ユーザーや検索エンジンがサイトの構造を把握しやすくなります。

最後に、URL構造を最適化することで、クリーンで記述的なURLを作成し、検索エンジンのインデックス作成に役立つ最新のXMLサイトマップを維持してください。

より多くの内部リンクを追加する

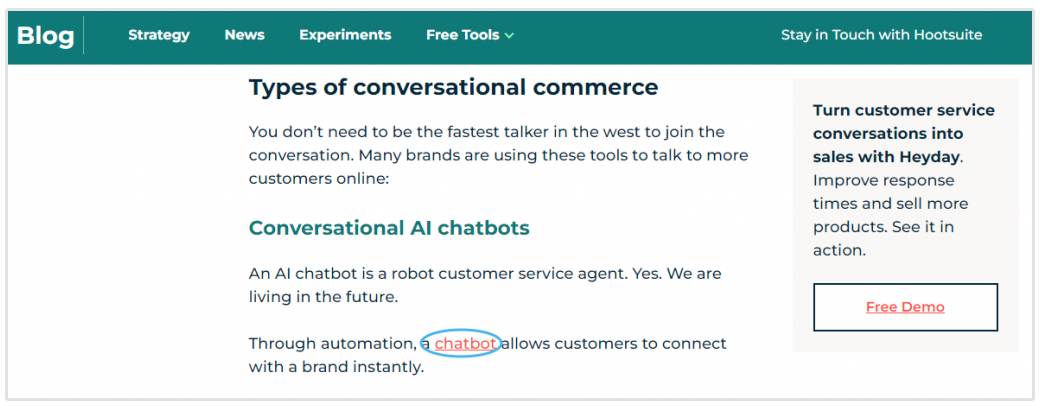

内部リンクは、検索エンジンのクローラーをあなたのウェブサイトを通して案内するのに重要です。

コンテンツ内に戦略的に内部リンクを追加することで、検索エンジンのボットが一つのページから別のページへと明確な経路をたどることができます。

サイト内の様々なページに内部リンクを追加することで、クローリング活動をより均等に分散させることができます。これにより、ウェブサイトの異なる部分が検索エンジンボットから注目を受け、一部のページが見過ごされることを防ぎます。

さらに、内部リンクは検索エンジンのボットがあなたのサイトの階層構造を深く掘り下げることを促します。重要なページが複数のソースからリンクされている場合、それは検索エンジンにとってそれらが重要であり、徹底的なインデックス作成に値するという信号となります。

ウェブサイトのパフォーマンスを向上させる

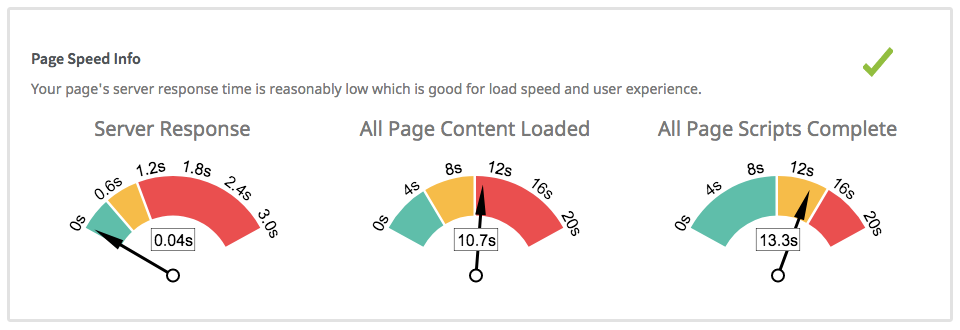

ウェブサイトのパフォーマンスを向上させることは、クロール率に直接影響を与えます。

高速に読み込むウェブサイトは、最適化された画像、最小限のHTTPリクエスト、効率的なサーバー応答時間、および軽減されたサーバー負荷により、検索エンジンのクローラーの効率を大幅に向上させることができます。

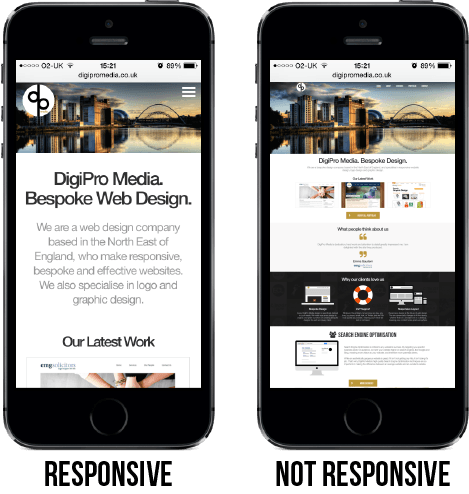

ウェブサイトがレスポンシブで、素早くロードされると、検索エンジンはそのページをより迅速かつ効率的にクロールすることができます。これは、検索エンジンのボットが割り当てられたクロール予算内でより多くの範囲をカバーできることを意味し、あなたのサイトのコンテンツのより包括的なインデックス作成につながります。

幸運にもほとんどのウェブサイトビルダーや現代のコンテンツ管理システムにはモバイル対応のテーマがあります。

その結果、性能の良いウェブサイトはユーザーエクスペリエンスを向上させ、検索エンジンのインデックス作成をより速く、より徹底的に行うことができ、SEOランキングに好影響を与える可能性があります。

Crawl Depth Issuesの原因とは?

クロールの深さに問題を引き起こすことがある一般的な要因は次のとおりです:

- 複雑なウェブサイト構造:過度に複雑な階層や深いナビゲーションパスを持つウェブサイトは、検索エンジンのボットが深いページに迅速に到達するのを難しくすることがあります。この複雑さは、過剰なサブカテゴリや非効率な組織化から生じる可能性があります。

- 不十分な内部リンク:あなたのウェブサイトが適切な内部リンク、特に深いページへのリンクが不足している場合、検索エンジンのボットはそれらのページを発見してクロールするのに苦労するかもしれません。不十分な内部リンクは、クローラーがたどることのできる経路を制限します。

- 孤立したページ:孤立したページとは、内部リンクが一切指していないページのことです。ページがウェブサイトの構造から隔離されていると、検索エンジンがそれらを簡単に見つけてインデックスすることができないかもしれません。

- 壊れたリンクとリダイレクトチェーン:壊れたリンクや不適切なリダイレクトはクローリングを妨げる可能性があります。検索エンジンのボットは行き止まりや循環するリダイレクトチェーンに遭遇し、より深いページへのアクセスを阻害されることがあります。

- ページの読み込み時間の遅さ:読み込み時間が遅いページは、検索エンジンのボットをイライラさせ、クロールを早期に放棄する原因となることがあります。読み込みが遅いページは、より深いコンテンツのインデックス作成を妨げる可能性があります。

- 重複コンテンツ:重複コンテンツの問題は、検索エンジンのボットを混乱させ、効率的でないクローリングを引き起こす可能性があります。ボットが同じコンテンツの複数のバージョンに遭遇すると、すべてのインスタンスを優先してインデックス化するとは限りません。

- Noindexタグ:「noindex」メタタグまたはディレクティブは、特定のページのインデックスを検索エンジンに控えるよう指示します。重要なページにこのタグが誤って設定されていると、検索結果での存在感が低下し、その可視性に影響を与える可能性があります。

- ウェブサイト構造の変更:適切なリダイレクションや内部リンクの更新なしに、ウェブサイトの構造を頻繁に変更すると、検索エンジンボットを混乱させることがあります。彼らは存在しないまたは古いページをクロールしようとするかもしれません。

結論

クロールの深さは、検索エンジンがあなたのウェブサイトのコンテンツを発見し、インデックスする方法において重要です。それはインデックス効率、SEOパフォーマンス、ユーザーエクスペリエンス、そしてGooglebotがあなたのページを再訪する頻度に影響を与えます。

ウェブサイトの構造、内部リンク、およびその他の技術的な側面を最適化することで、重要なコンテンツが検索エンジンから適切な注目を受けることを保証できます。